ФЕЉТОН - У ТОКУ ЈЕ ПРАВИ ЕЛЕКТРОНСКИ РАТ: Корисници не знају да ли имају посла са човеком или машином

У ТОКУ је прави рат, а његов исход тек ће се одиграти. У сајбер-биткама с једне стране учествују творци ботова, који се труде да програмирају све савршеније лажне профиле, теже уочљиве, а с друге они који се баве откривањем и дају максимум да одрже корак са све сложенијим ботовима, као и да развију још ефикасније методе за њихово препознавање.

ТЕХНИКА Поруке на друштвеним мрежама су једноставне, Фото Архива

То је трка у наоружању у којој противници непрестано настоје да надмаше једни друге. У Националном истраживачком савету Италије у Пизи упознали смо Стефана Крешија, једног од најмарљивијих истраживача на пољу лова на ботове. Рекао нам је да је последњих година интересовање за ову област достигло енормне размере. "Број објављених радова о откривању ботова вртоглаво је порастао од 2012. до данас."

"Ботометер" је тренутно несумњиво у средишту пажње у већини студија о ботовима. После Емилија Фераре појавило се сијасет истраживача из целог света који су га користили како би стекли представу о количини лажних идентитета који "загађују" друштвене мреже. Ипак, није увек једноставно да се утврди права природа неког профила, поготово ако нам алгоритам машинског учења покаже бројку негде на средини између нула (сигурно човек) и пет (сигурно бот). Друге технике које су на цени код оних који се баве откривањем ботова, заснивају се на графиконима. "Те технике", објашњава Креши, "усмерене су пре свега на атипичну повезаност унутар неке групе налога, занемарујући карактеристике појединачних налога".

ЕМИЛИО Ферара и његове колеге су то већ приметили када су истраживање урађено током америчких избора 2016. године поновили и за време избора на пола председничког мандата 2018. и добили сасвим другачије резултате. Пре свега, изгледа да су ботови, премда су и даље у игри, претрпели корените промене. Користећи свој алгоритам за класификацију налога, научници су пронашли 31.000 ботова који су твитовали о изборним темама. Ипак, за разлику од својих претходника, нови ботови нису само неуморно ретвитовали, већ су били кадри да и сами понуде одређене садржаје и комуницирају с правим корисницима. А људи, пошто их вероватно нису препознали као лажне, одговарали су ботовима и преносили њихове поруке. Аутори студије схватили су да је реч о знатно сложенијим ботовима. А сва је прилика да је у њих много више и уложено, јер само програмирање алгоритма који ће ретвитовати одређене поруке не кошта много, нити изискује много утрошеног времена (и новца), док је знатно скупље опремити га неким видом аутономног језика и интелигенције.

ОДБРАНА ОД ЛАЖНИХ ПРОФИЛА

ДРУШТВЕНЕ платформе, у настојању да се одбране од лажних профила, користе најразличитије оружје. Неке се, на пример, претежно ослањају на пријаве својих корисника. Такав је случај с "Фејсбуком", који након пријаве покреће процес где већином задужена лица прегледају те профиле, настојећи да увиде да ли се само недолично понашају или су ботови. Не заостаје ни "Твитер": за свега два месеца - од маја до јуна 2018. године - уклоњено је више од седамдесет милиона налога.

ЗНАТАН број тих ботова није подржавао овог или оног кандидата у предизборној трци, није се трудио да заоштри расправу, или да убеђује грађане, већ је само објављивао анкете на тему избора. На пример: "Само уколико излазиш на гласање 6. новембра, одговори на питања из ове анкете", "За коју странку ћеш гласати и зашто?", "Сматраш ли да је исправно што на гласачком месту мораш да покажеш неки лични документ?" "Ретвитуј ако си сагласан са овим: потребно је да на сваком изборном месту приликом гласања надзор врше и федерални агенти."

Тај вид понашања, у погледу временске усклађености, количине порука, као и комуникације коју бот успева да оствари, веома је налик на поступање људи, и то у толикој мери да постоји све већа опасност да у блиској будућности уопште нећемо моћи да их разликујемо од правих корисника. Када је реч о временској усклађености, Ферара и његове колеге истичу да напреднији ботови не ретвитују исту поруку много пута (као што бисмо од машине очекивали), чешће је пренесу само једном (али са мноштва различитих налога, што наводи на сумњу да постоје добро организоване ботовске мреже).

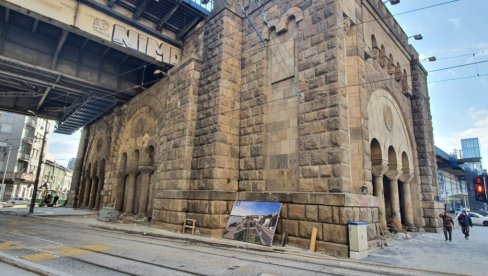

"ВЕШТАЧКА интелигенција је узнапредовала џиновским корацима. Данас алгоритми састављају текстове и пишу књиге. Разуме се, то нису квалитетни текстови, али ако узмемо у обзир појединачне твитове већ смо стигли дотле да је практично немогуће разликовати да ли су их написали људи или роботи", објашњава Ферара. Будући да су поруке које се објављују на друштвеним мрежама већ по природи једноставне, њихов речник је сиромашан и често су кратке. "Сложенији ботови могу да се служе и жаргоном, скраћеницама, акронимима, итд.

До јуче се говорило да је немогуће да се машина програмира да ствара садржаје који се не разликују од човековог писања, док је данас то уверење ишчезло", наставља научник. И то не важи само за алгоритме који служе за откривање и морају да буду све сложенији како би могли да препознају и најнапредније роботе, већ и за саме кориснике друштвених мрежа. "У нашој студији о изборима на пола председничког мандата у Америци забележили смо пад утицаја ботова на друштвеним мрежама у односу на претходне председничке изборе. Али не знамо да ли је то условљено префињенијим човековим расуђивањем, или неспособношћу програмских класификатора да препознају напредније ботове", закључује истраживач.

ЈЕДНО Крешијево истраживање долива уље на ватру и показује да алгоритми нису једини који наилазе на тешкоће, будући да ни људи најчешће не препознају најсавршеније ботове. Да би то доказали, научници су употребили платформу за филтрирање података Crowdflower, где стотине људи ручно поставља ознаке на текстове. Циљ је да се направи мноштво образаца како би се алгоритми оспособили за машинско учење. Дакле, да илуструјемо примером: ако хоћу да направим програм који може да препозна да ли неки текст садржи речи мржње (у сврху израде студије о говору мржње), употребићу Crowdflower за прикупљање хиљаде израза са ознаком "мржња" и подједнак број оних који су означени као "није мржња".

У Крешијевом експерименту задатак обележивача на Crowdflower био је да утврде да ли иза одређене групе профила стоје људи или програмерски алгоритми. Међутим, они нису знали да научници већ имају одговоре и желе само да измере њихову способност уочавања ботова.

Резултат је био забрињавајући. Наиме, међу најразвијенијим ботовима они су препознали тек сваког четвртог. А то, другим речима, значи да ни људи не знају да ли имају посла с правим саговорником или машином. Или, прецизније, препознају људе као такве, али су склони да сматрају за људе и профиле који то нису. То значи да се ботови све успешније прерушавају (за разлику од једноставнијих лажних пратилаца, који су, напротив, у том експерименту уочени у 91 одсто случајева). Студија нам открива још једну горку истину: алгоритми за откривање ботова које користе саме платформе још су мање успешни него људи. "Твитер" је 2017. године, у време када је рађен овај експеримент, успевао да пронађе свега 60 одсто лажних пратилаца и четири одсто напреднијих ботова.

СУТРА: ИЗБОРИ НА ДРУШТВЕНИМ МРЕЖАМА

Препоручујемо

ФЕЉТОН - ТРИКОВИ ЗА НАВЛАЧЕЊЕ КУПАЦА: У тренутку продаје бот с пуно пратилаца више вреди

14. 09. 2021. у 18:00

ФЕЉТОН - НАЈЕЗДА КИБЕРНЕТИЧКИХ ТРУПА: Појединац управља стотинама налога

13. 09. 2021. у 18:00

"НЕМЦИ, ОДАКЛЕ ВАМ ПРАВО?" Порука из Русије у вези са Резолуцијом о Сребреници: Ви сте истребили 10 милиона људи!

УЧЕСНИЦИ међународне седнице о безбедности у Санкт Петербургу дошли су до закључка да је резолуција о наводном геноциду у Сребреници, коју Немачка промовише у УН, лицемерје и извртање чињеница, изјавио је секретар Савета безбедности Русије Николај Патрушев.

25. 04. 2024. у 18:08

ЗЕЛЕНСКИ ТРАЖИ ТРЕЋИ СВЕТСКИ РАТ? Украјински председник покушава да увуче НАТО диретно у рат са Русијом (ВИДЕО)

У АПЕЛУ западним савезницима, украјински председник Владимир Зеленски позвао је на снажан став, сличан оном у Израелу и околном региону.

25. 04. 2024. у 18:00

ТРЕЋА НЕДЕЉА У ЗАВОЈИМА: Нина показала ране на ногама

ГЛУМИЦА Нина Јанковић доживела је неугодну повреду.

22. 04. 2024. у 10:38

Коментари (0)